جعل در سینما و موسیقی با هوش مصنوعی / برای سرگرمی به جایی برده میشوید که با پای خودتان نرفتید

ماجرای جعل صدا و تصویر شخصیتها به داستانی عادی تبدیل شده است اما بهای این سرگرمی هیجانانگیز ترویج محتوای غیرواقعی است که از قضا قانون نیز در مقابل آن سکوت کرده است.

به گزارش پارسینه، به تعبیر یک نوجوان ایرانی نهایت استفاده ما از هوش مصنوعی شده است تقلید صدای هایده. این تعبیر تلخ از قضا درست است. آن هم در شرایطی که در کشورهای دیگر پیشرفت هوش مصنوعی در حوزههای مختلف زندگی قابل توجه است.

به ویژه در چند سال اخیر استفاده بیقاعده و صرفاً سرگرم کننده هوش مصنوعی موجی از محتواهای غیرواقعی را در فضای مجازی جابه جا میکند. به طوریکه شما به سادگی میتوانید به تصاویر، صداها و اتفاقات شخصی زندگی بازیگران و خوانندگان برسید.

جعل چهره و صدای بازیگران

در قابلیتهای جدید هوش مصنوعی میتوان تصاویر، فیلمها و صداهایی جعلی ساخت. چالشهایی که باعث شکلگیری اصطلاح «جعل عمیق» در دسته اخبار جعلی یا Fake Newsها شده است.

در «جعل عمیق» با استفاده از تصویر یا صدای افراد، نسخهای جعلی میسازند و صدایی را تولید میکنند که هرگز آن فرد به زبان نیاورده و یا ویدیو و عکسی از او میسازند که فرد هرگز در آن حضور نداشته است. به طور کلی تولید محتوای جعلی برای افراد مشکلآفرین است، اما صوت و تصویر، بیش از متون نوشتاری دست به دست میشود و حتی کسانی که حوصله خواندن متنها را ندارند، به راحتی زمانی را به دیدن و شنیدن سایر محتواهای جعلی اختصاص میدهند و این محتوا ماندگاری بیشتری هم در اذهان عمومی دارند.

از سویی دست به دست شدن و انتشار در حجم وسیع موجب میشود که هیچگاه این محتواها به صورت کامل از بین نروند و با یک جستجوی ساده بتوان به آنها رسید.

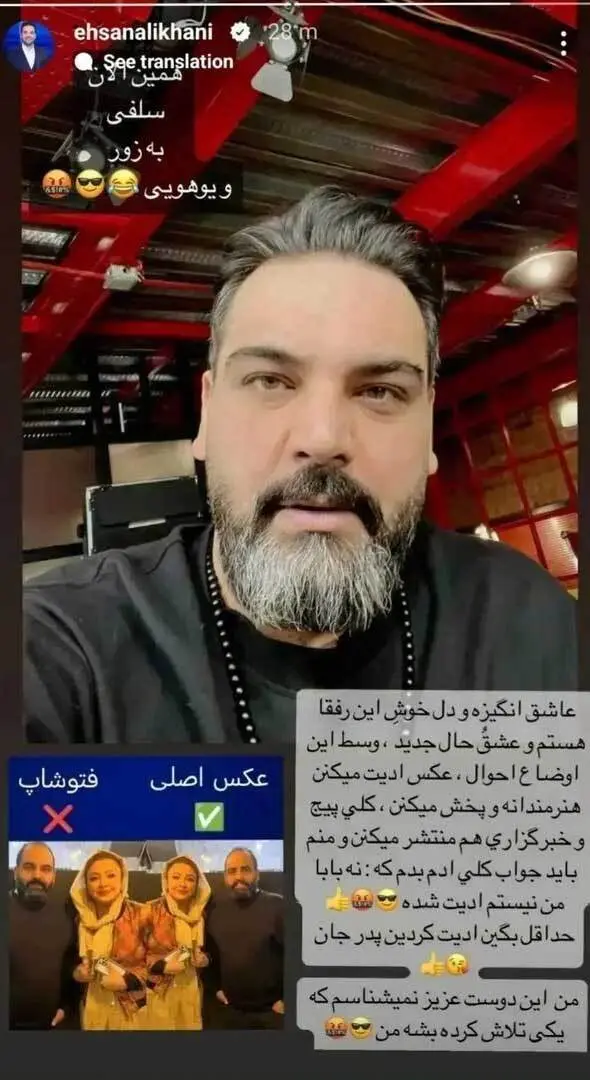

به عنوان مثال انتشار عکس جعل شده احسان علیخانی در کنار مهلقا باقری و همچنین دستکاری تصاویر الناز شاکردوست بر تخت بیمارستان و گذاشتن چهره ترانه علیدوستی به جای او، آن هم درست در روزهایی که خبر بستری شدن این بازیگر در بیمارستان دست به دست میشد، نمونههایی از استفاده زرد از هوش مصنوعی است. موضوعی که احسان علیخانی را وادار کرد تا با انتشار یک استوری در صفحه اینستاگرام خود نسبت به آن واکنش نشان دهد و بنویسد: «عاشق انگیزه و دلِ خوش این رفقا هستم و عشقُ حال جدید، وسط این اوضاع احوال، عکس ادیت میکنن، عکس اصلی و هنرمندانه فتوشاپ و پخش میکنن، کلی پیج و خبرگزاری هم منتشر میکنن و منم باید جواب کلی آدم بدم که: نه بابا من نیستم ادیت شدهام. حداقل بگین ادیت کردین پدر جان. من این دوست عزیز نمیشناسم که یکی تلاش کرده بشه من».

همچنین استفاده نامناسب از چهره و صدای خسرو شکیبایی در مراسم افتتاحیه جشنواره فیلم فجر موجب شد خانواده خسرو شکیبایی از نحوه شبیهسازی این هنرمند فقید انتقاد کنند.

پوریا شکیبایی پسر زنده یاد خسرو شکیبایی با انتشار ویدیویی در فضای مجازی بیان کرد که به خاطر ناراحتی زیاد مادرش پیام اعتراضی را منتشر کرده و گفت که بهتر بود در تولید چنین محتوایی صداقت در کلام و معرفت در امانتداری رعایت میشد.

او همچنین اشاره کرده که با خودش و مادرش در خصوص این محتوا هیچ تماسی گرفته نشده و شاید اگر این اتفاق میافتاد کمک بهتری برای خلق یک اثر مقبولتر صورت میگرفت.

چطور تشخیص دهیم اثری جعلی است؟

هرچند از تقلید صدایهایده و پاشایی گرفته تا تغییر چهره بازیگران زن و مرد ایرانی به کررات دیده میشود اما مهمترین آسیب استفاده نادرست از هوش مصنوعی صدمه زدن به حریم خصوصی و خدشه به شخصیت هنری و اجتماعی این افراد است.

افرادی برای سرگرمی محتوایی از حضور فلان فرد در فلان مکان تولید میکنند که هیچگاه با پای خود به آنجا نرفته است.

با این وجود هوش مصنوعی ابزار تولیدی انسان است و میتوان با بررسی محتوا در بیشتر مواقع پی به جعلی بودن آن برد. از جمله میتوانید از شیوههایی که ذکر آن میرود استفاده کنید.

۱-بزرگنمایی کرده و با دقت نگاه کنید

بسیاری از تصاویر تولید شده توسط هوش مصنوعی در نگاه اول واقعی به نظر میرسند.

به همین دلیل اولین پیشنهاد ما این است که به تصویر دقت کنید. برای انجام این کار تصویر را با بالاترین وضوح ممکن جستجو کنید و سپس روی جزئیات زوم کنید. بزرگ کردن تصویر ناهماهنگیها و خطاهایی را نشان میدهد که ممکن است در نگاه اول شناسایی نشده باشند.

۲-منبع تصویر را پیدا کنید

اگر مطمئن نیستید که یک تصویر واقعی است یا توسط هوش مصنوعی تولید شده سعی کنید منبع آن را پیدا کنید.

با خواندن نظرات منتشر شده توسط سایر کاربران در زیر تصویر ممکن است بتوانید اطلاعاتی در مورد جایی که تصویر برای اولین بار پست شده را مشاهده کنید یا ممکن است یک جستجوی عکس معکوس انجام دهید. برای انجام این کار تصویر را در ابزارهایی مانند Google Image Reverse Search، TinEye یا Yandex آپلود کنید و ممکن است منبع اصلی تصویر را پیدا کنید. نتایج این جستجوها هم چنین ممکن است پیوندهایی را به بررسی واقعیت انجام شده توسط رسانههای معتبر نشان دهد.

۳-به تناسب بدن توجه کنید

آیا افراد تصویر شده دارای تناسب اندام صحیحی هستند؟ این غیرمعمول نیست که تصاویر تولید شده توسط هوش مصنوعی در رابطه با تناسبها تفاوتهایی را نشان دهند. ممکن است دستها خیلی کوچک یا انگشتان خیلی بلند باشند یا آن که سر و پا با بقیه بدن مطابقت ندارند. برای مثال، در تصویری جعلی این گونه نشان داده شده که پوتین در برابر شی زانو زده است. با این وجود، با دقت به تصویر میتوان مشاهده کرد که کفش فرد زانو زده به طور نامتناسبی بزرگ و پهن است. گوشها نیز دراز به نظر میرسند. سر نیمه پوشیده نیز بسیار بزرگ است و با سایر اندامهای بدن تناسبی ندارد.

۴-مراقب خطاهای معمول هوش مصنوعی باشید

دستها در حال حاضر منبع اصلی خطاها در برنامههای تصویر هوش مصنوعی مانند Mid journey یا DALL-E هستند. برای مثال در تصویری که ازپوتین منتشر شد مامور پلیسی که در سمت چپ اوست انگشت ششم دارد! هم چنین در تصویر منتشر شده از پاپ فرانسیس که جعلی است او تنها چهار انگشت درست در تصویر دارد و انگشتان او در سمت چپ به طرز غیر عادی بلند به نظر میرسند. این عکسها جعلی هستند.

سایر خطاهای رایج در تصاویر تولید شده توسط هوش مصنوعی شامل افرادی با دندانهای بسیار زیاد هستند. هم چنین، فریم عینکهایی که به طرز عجیبی تغییر شکل پیدا کرده اند که در تصاویر ایجاد شده توسط هوش مصنوعی دیده میشوند. هم چنین، در بسیاری از این تصاویر گوشها اشکال غیر واقعی دارند مانند تصویر جعلی از شی و پوتین. هم چنین، سطوحی مانند گوشههای کلاه ایمنی برای برنامههای مبتنی بر هوش مصنوعی مشکلاتی ایجاد میکنند و گاهی اوقات تصویر از هم پاشیده به نظر میرسد مانند آن چه در تصویر بازداشت ادعایی پوتین دیده میشود.

با این وجود، هنری آژدر متخصص هوش مصنوعی هشدار میدهد که نسخههای جدیدتر برنامههایی مانند Mid journey در به تصویر کشیدن دستها بهتر عمل میکنند. این بدان معناست که کاربران نمیتوانند در بلند مدت روی تشخیص این نوع اشتباهات حساب باز کنند.

-آیا تصویر مصنوعی و صاف به نظر میرسند؟

برنامه Mid journey به طور خاص تصاویر بسیاری را ایجاد میکند که برای واقعی بودن بیش از حد خوب به نظر میرسند. احساس درونی خود را در اینجا دنبال کنید: آیا چنین تصویر کاملی با افراد بی عیب و نقص واقعا میتواند واقعی باشد؟ آندریاس دنگل از مرکز تحقیقات هوش مصنوعی آلمان به گفته است: چهرهها خیلی خالص هستند و لباسهایی که نشان داده میشوند نیز بسیار هماهنگ میباشند. پوست افراد در بسیاری از تصاویر هوش مصنوعی اغلب صاف و عاری از هرگونه سوزش است و حتی موها و دندانهای آنان بی عیب و نقص است. این موارد معمولا در زندگی واقعی صدق نمیکنند.

بسیاری از تصاویر نیز دارای ظاهری هنرمندانه، براق و پر زرق و برق هستند که حتی عکاسان حرفهای نیز در عکاسی استودیویی برای دستیابی به آن مشکل دارند. اغلب به نظر میرسد ابزارهای مبتنی بر هوش مصنوعی تصاویر ایدهآلی را طراحی میکنند که قرار است بی نقص باشند و تا آنجا که ممکن است انسانها را خوشحال کنند.

۶-پس زمینه را بررسی کنید

پس زمینه یک تصویر اغلب میتواند نشان دهد که آیا دستکاری شده است یا خیر.

در اینجا نیز اجسام میتوانند تغییر شکل یافته به نظر برسند. برای مثال، به چراغهای خیابان توجه کنید. در موارد معدودی برنامههای هوش مصنوعی افراد و اشیاء را شبیه سازی کرده و دو بار از آنان در یک تصویر استفاده میکند و غیر معمول نیست که پسزمینه تصاویر هوش مصنوعی محو شود. اما حتی این تاری میتواند حاوی خطا باشد یک پس زمینه به طور مصنوعی تار به نظر میرسد.

در نتیجه، بسیاری از تصاویر تولید شده توسط هوش مصنوعی در حال حاضر هنوز با قدری تحقیق قابل حذف هستند. با این وجود، فناوری در حال بهتر شدن است و احتمالا این اشتباهات در آینده نادرتر میشوند.

فرد متضرر به کجا پناه ببرد؟

هنوز قوانین مربوط به هوش مصنوعی در ایران قابلیت شکایت و پیگیری از سوی فرد متضرر را ندارد. به ویژه که در بیشتر مواقع هویت تولید کننده محتوا نامشخص است.

این در حالی است که بریتانیا، اتحادیه اروپا و آمریکا از سالها قبل تدوین و طراحی قوانینی در خصوص هوش مصنوعی را ضروری دیده و آغاز کردهاند.پیش از این از سوی معاونت علمی، فناوری و اقتصاد دانشبنیان رئیس جمهور اعلام شده که موضوع مطالعات تطبیقی قوانین هوش مصنوعی دنیا در ایران آغاز شده است. هر چند فعلاً از خروجی کار خبری نیست.

امروز اگر عکس جعلی شما در کنار افرادی که نمیشناسید در فضای مجازی دست به دست شود، عملاً قادر به مهار آن نیستید و آیا چنین پدیده مخرب فرهنگی به اندازه کافی هراسآلود نیست که در خصوص ساز و کار قانونی آن اندیشیده شود؟

منبع: خبر فوری

.svg)

ارسال نظر